Problème des gros volumes et de la distribution

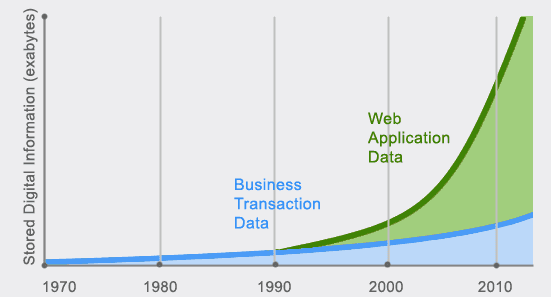

Big data

Fondamental : Distribution

Passage du serveur central (main frame) à des grappes de machines modestes :

pour gérer l'explosion des données

à cause de l'évolution du hardware

Problème de la performance

La performance de jointures exécutées sur plusieurs machines est mauvaise, or la normalisation augmente les jointures.

Problème de la gestion du contrôle d'intégrité et des transactions

il faut intervenir sur plusieurs machines en réseau à chaque modification des données et synchroniser les informations entre ces machines.

Problème de l'identification unique par les données

Comment savoir qu'une autre instance n'est pas en train d'affecter une même donnée clé.

Attention :

Ces questions doivent être traitées sachant que les machines tombent en panne et que les réseaux sont victimes de coupures : est-ce que tout est mis en attente chaque fois qu'un élément du système dysfonctionne ?

Si oui, plus le système est grand plus il est fragile, ce n'est pas tenable.

Si non, on aura des incohérences, est-ce tenable ?

Fondamental :

Il y a une équation à résoudre entre les paramètres de distribution, performance et cohérence.